Meta може припинити розробку ШІ-систем, які вважає занадто ризикованими

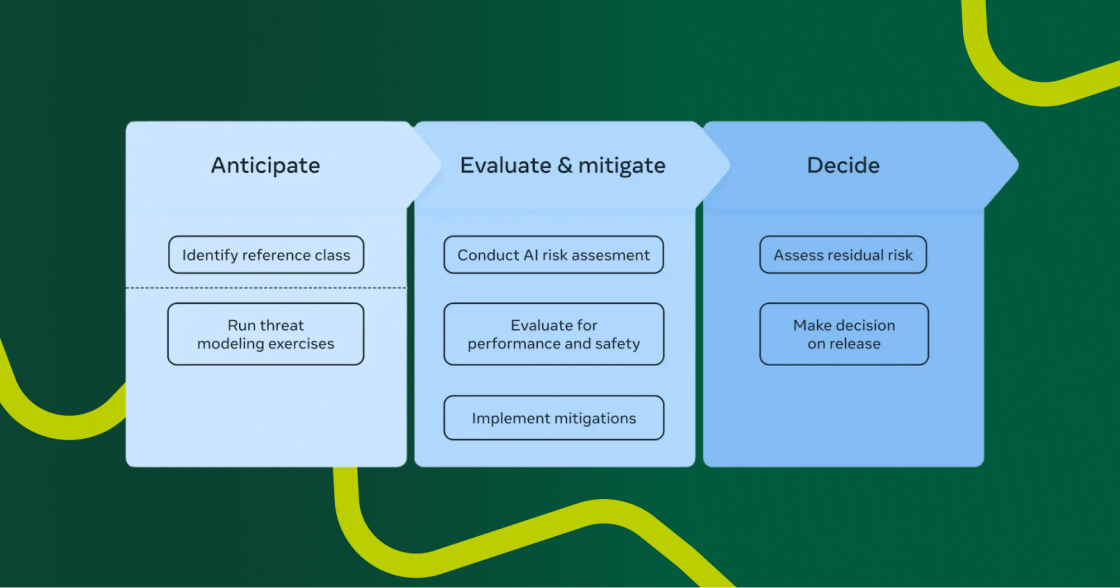

Meta оприлюднила Frontier AI Framework — документ, у якому визначає умови, за яких компанія може обмежити або припинити розробку власних ШІ-систем. Зокрема, Meta виокремлює дві категорії: високий ризик і критичний ризик.

До систем високого ризику належать моделі, здатні допомагати в кіберзагрозах чи розробленні небезпечних речовин, але не з абсолютною надійністю.

Критично небезпечні системи, за визначенням Meta, можуть мати катастрофічні наслідки, які неможливо мінімізувати в контексті їхнього використання.

Якщо ШІ-модель є високоризикованою, то компанія обмежить її внутрішнє використання та відкладе випуск до зниження рівня загрози. Якщо ж систему визнають критичною, Meta вживатиме додаткових заходів безпеки або припинить її розроблення.

Ця стратегія стала відповіддю на критику щодо відкритого підходу Meta до розвитку ШІ. Її ШІ-моделі Llama вже завантажили сотні мільйонів разів. Проте відомо, що деякі з них використали недружні держави для створення військових рішень.

Meta зазначає, що її підхід до розробки ШІ буде змінюватися залежно від розвитку технологій і глобальних ризиків.

Джерело: Tech Crunch