Компанія Google пояснює принципи роботи Googlebot — подаємо основні тези

Компанія Google опублікувала оновлення в Search Central, де пояснює, як працює програма Googlebot. У матеріалі розповідають про процес сканування вебсторінок, а також надає рекомендації для оптимізації роботи сайтів.

Адаптували матеріал для читачів Медіа Inweb.

Як працює Googlebot

Googlebot виконує сканування сторінок за таким алгоритмом:

- Завантажує HTML сторінки.

- Передає контент у Web Rendering Service (WRS), де відбувається рендеринг.

- WRS завантажує додаткові ресурси — JavaScript і CSS, зазначені в HTML.

- Усі ресурси об’єднуються для формування завершеної сторінки.

Googlebot працює в межах так званого crawl budget — обсягу ресурсів, які Google виділяє на сканування кожного сайту. Crawl budget залежить від розміру сайту, його популярності та технічної оптимізації.

Як оптимізувати роботу сайту

Google надав низку рекомендацій для покращення ефективності сканування:

- Потрібно мінімізувати ресурси — уникати завантаження зайвих файлів, які не впливають на досвід користувача.

- Використовувати окремі домени або CDN — це зменшить навантаження на основний сервер.

- Обережно застосовувати кешуючі параметри. Наприклад, не змінювати URL, якщо контент залишається незмінним — це допоможе уникнути непотрібних повторних запитів.

Як відстежувати роботу Googlebot

Для моніторингу активності Googlebot компанія рекомендує два основні інструменти:

- Логи сервера. Вони дозволяють побачити, які URL запитував сканер.

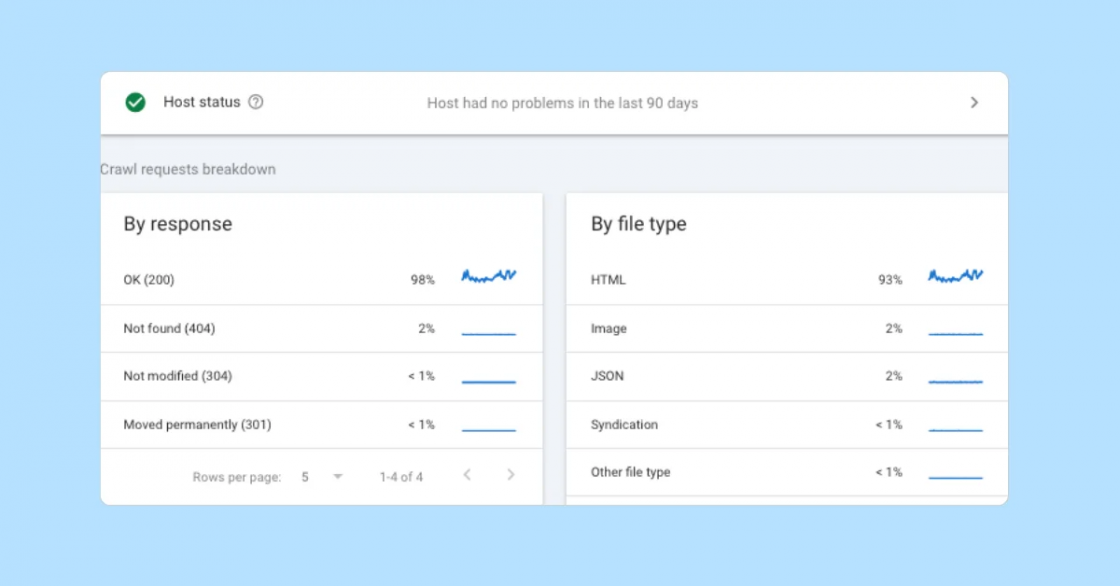

- Звіт Crawl Stats у Search Console. Він надає деталізовану інформацію про частоту сканування, виявлені помилки та навантаження на сайт.

Google також зазначає, що блокування доступу до важливих ресурсів — JavaScript або CSS — через файл robots.txt може завадити правильному індексуванню сторінок і знизити їхню позицію у пошуковій видачі.

У оновленні наголошують, що оптимізація ресурсів і правильне управління часом сканування сайту (crawl budget) допоможуть Google швидше і точніше обробляти ваші сторінки. Таким чином, використання сучасних інструментів дозволяє уникати технічних помилок і покращити позиції сайту в пошукових результатах.

Джерело: Swipe Insight