Чому сайт погано індексується, що таке індексація і які існують методи прискорення

Проблема індексації посадкових сторінок — одна з основних, з якою стикається майже кожен власник сайту. Індексація — додавання інформації про ваш сайт в базу даних пошукових систем. Сторінки, яких немає в індексі, користувачі не зможуть знайти, отже — трафіку на них не буде.

Пошукові системи сканують сайти в інтернеті на предмет якісних документів, що задовольняють попит користувачів. Пошуковики зацікавлені, щоб база сайтів була максимально повною та актуальною, тому регулярно сканують всі, відомі їм, сайти в пошуках нового контенту. Є цілі сайти і / або окремі документи, які рідко сканують пошукові системи або які не скануються зовсім. У статті ми розберемо основні моменти, що впливають на швидкість індексації документів.

Причини поганої індексації сайту

Щоб розібратися, чому сайт погано індексується, потрібно визначитися з поняттями «краулінга» і «краулінгового бюджету».

Краулінг — це процес сканування сторінок ботами пошукових систем. Основна мета краулінга — знайти якомога більше корисних і актуальних документів.

Краулінговий бюджет — це ліміт, який виділяється кожному сайту на сканування. Іншими словами це обмеження кылькості сторінок, які пошуковий робот може просканувати в певний проміжок часу. Краулінговий бюджет розраховується для кожного сайту окремо, виходячи з частоти оновлення контенту, якості ресурсу, відповіді сервера, розміру сторінок та інших параметрів.

Логічно, якщо на сайті 10 сторінок і нічого не змінюється роками — роботи рейтингів не будуть сканувати такі сайти часто. Немає сенсу витрачати ресурси на це завдання.

Виходячи з поняття «краулінга» і нашого SEO-досвіду розглянемо помилки та способи їх виправлення.

Як дізнатися, що сайт погано індексується?

Сайт або сторінка рідко індексується, якщо дата збереженої копії (кешу) понад два тижні. Перевіряємо дату кешу документа в Google через оператор cache: cache:inweb.ua

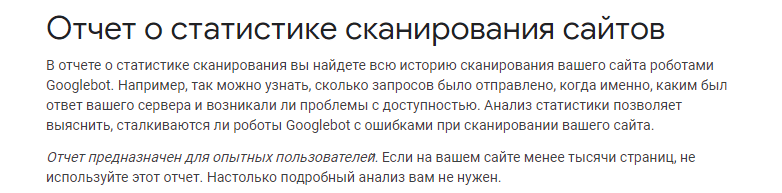

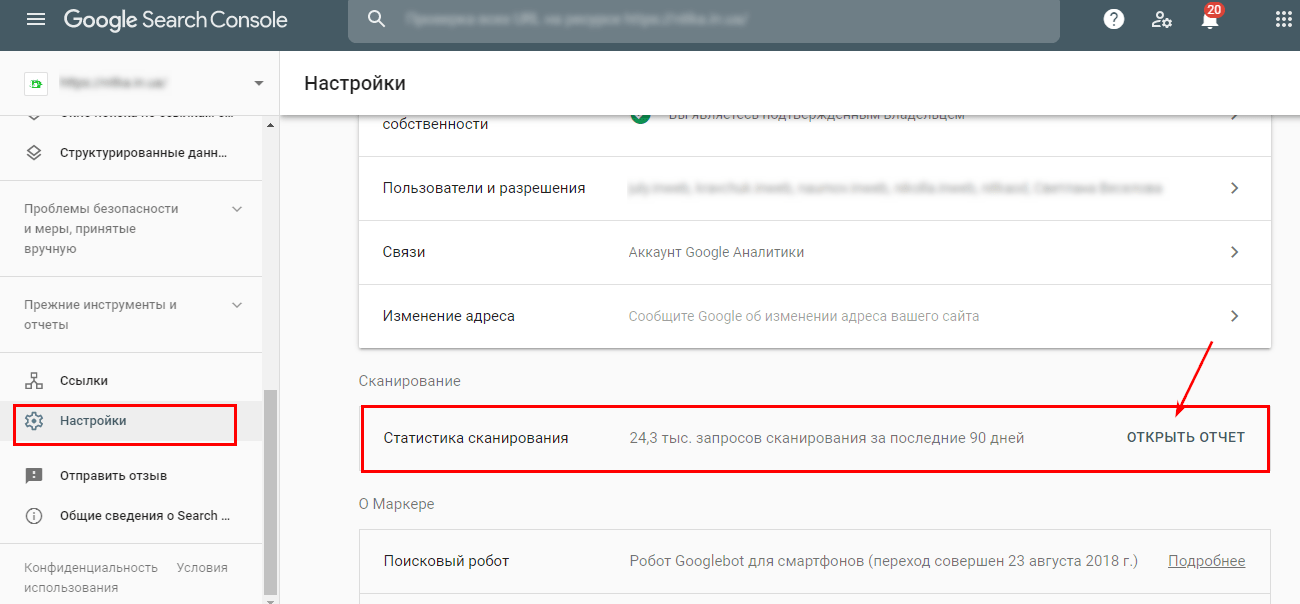

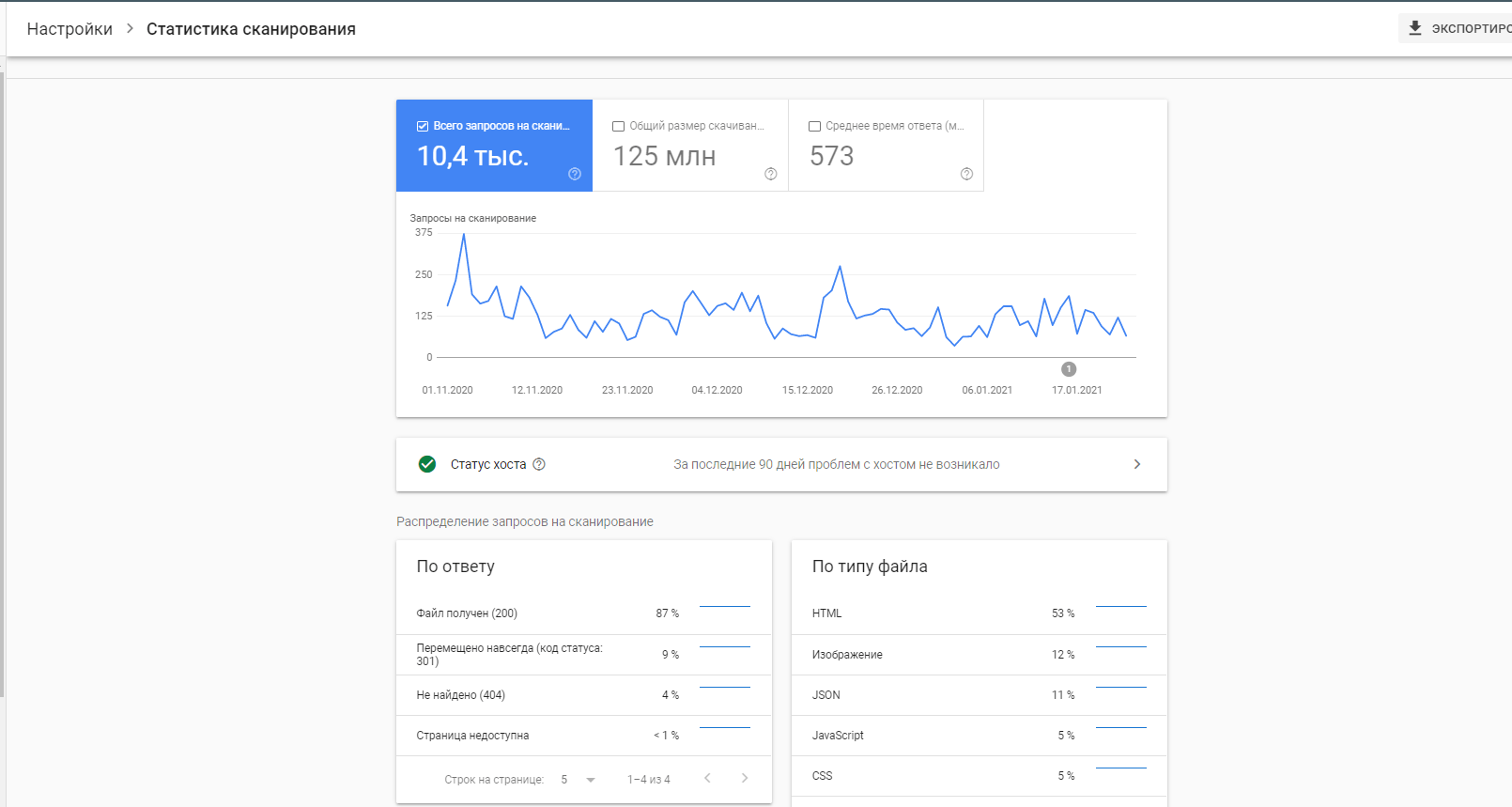

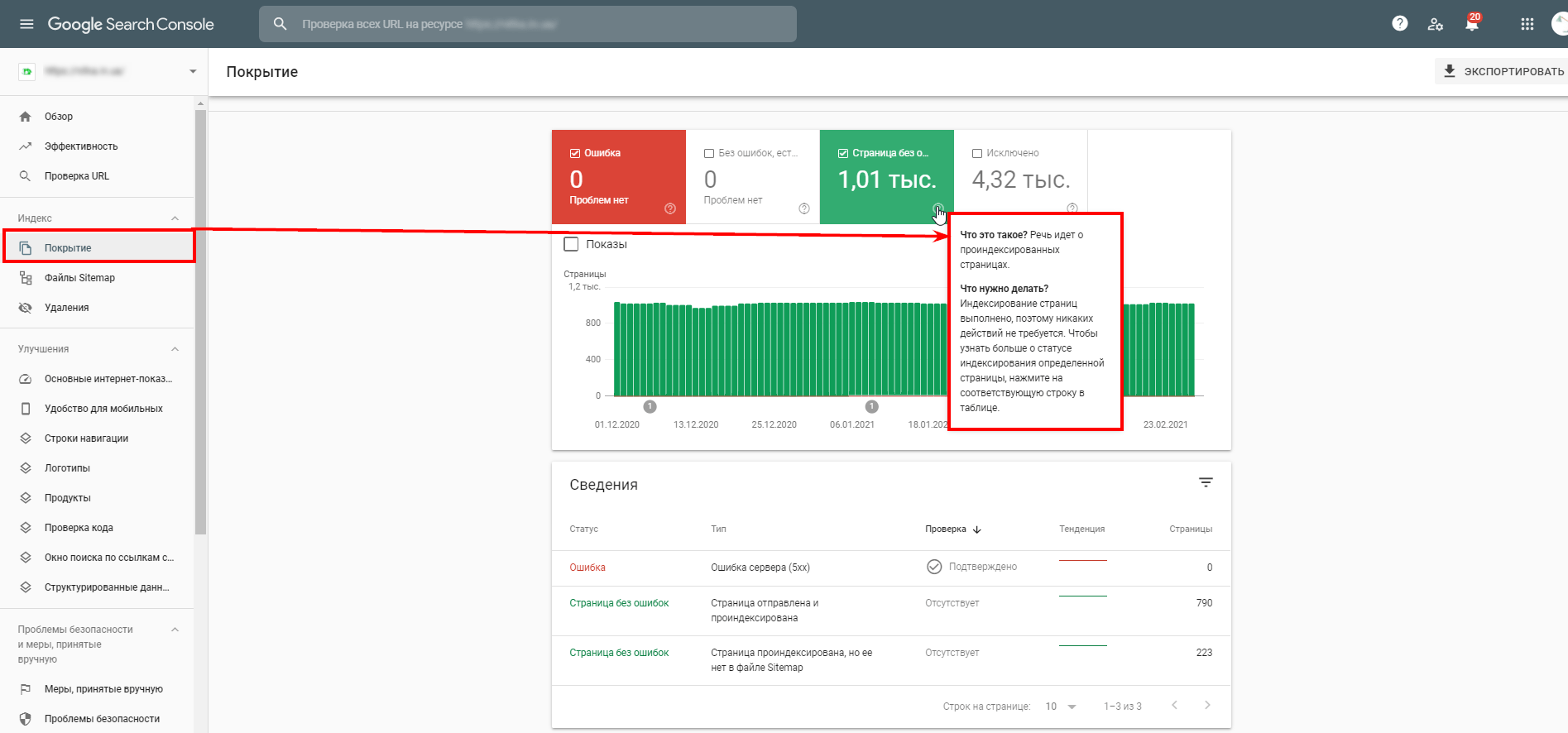

Якщо даті кешованої копії понад місяць — з індексацією серйозні проблеми. Результати сканування вашого сайту пошуковими системами можна подивитися в спеціальних звітах Google. Для пошукової системи Google даний звіт доступний в сервісі Search Console. Ось що пише Google про свій звіт:

Приклад звіту в Google Search Console:

Найчастіше, проблема краулінга стосується тільки дуже великих сайтів. Якщо ваш сайт має до 1000 сторінок і вони індексуються раз на місяць або рідше, основна причина поганої індексації десь на самих сторінках. Розглянемо основні помилки, що впливають на сканування та індексування сторінок.

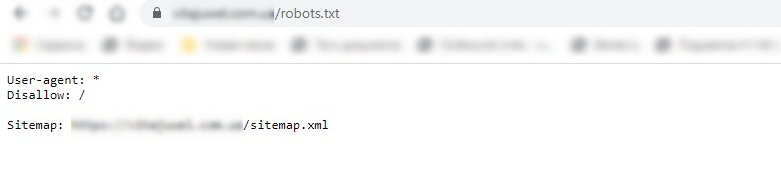

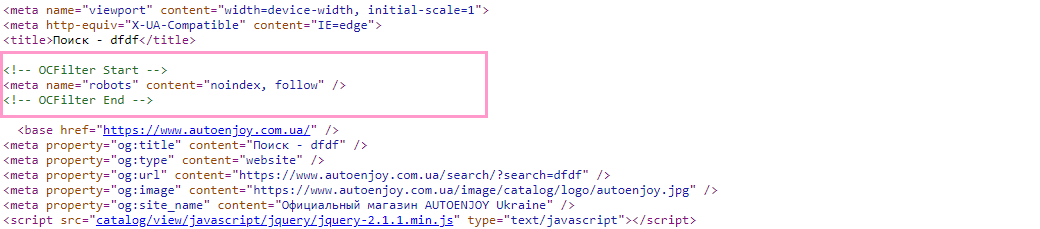

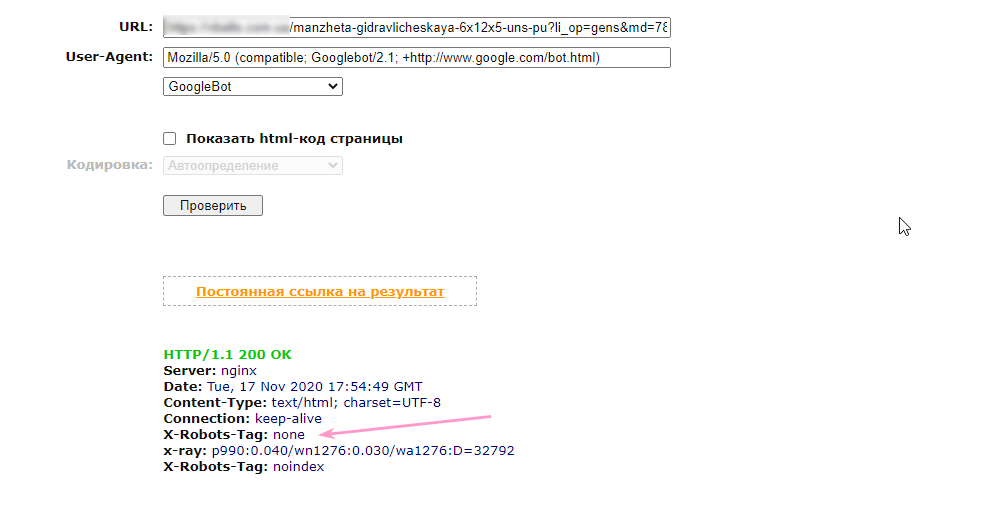

- Закриття сайту або окремих сторінок у файлі robots.txt, noindex, X-Robots tagОкремі сторінки або сайт в цілому можуть бути закритими від індексації всіх пошукових систем або якоїсь конкретної. В такому випадку сайт не буде скануватися, потрібні сторінки потрапляти в індекс, підсумок — ви не зможете ранжуватися в пошуку.Приклад закритого сайту від індексації у файлі robots.txt:

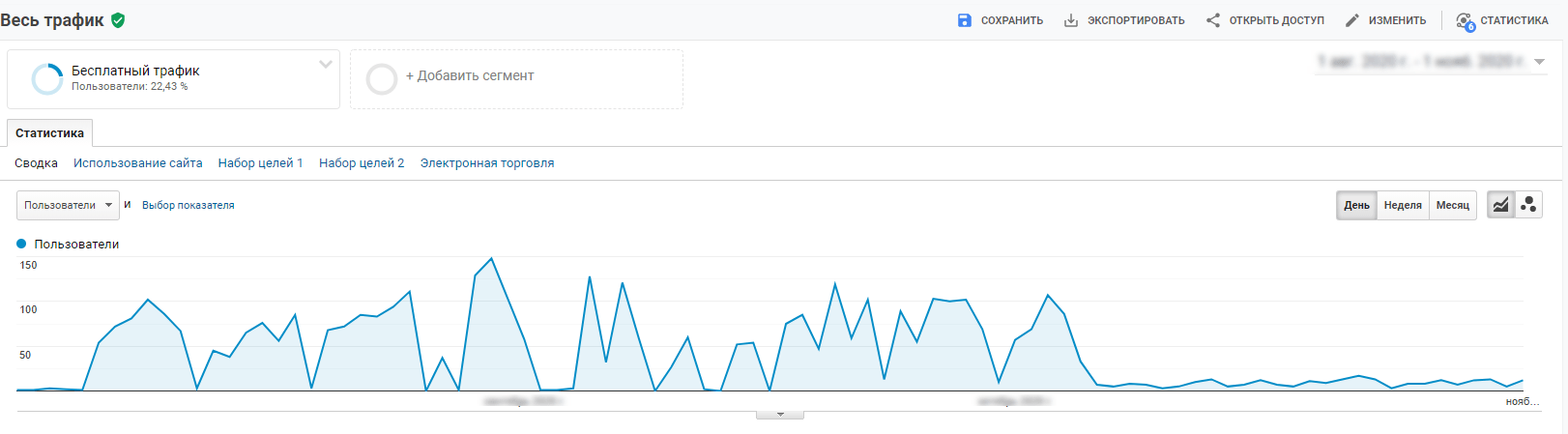

- Фільтр, санкції від пошукових систем. Щоби надавати користувачам якісний контент, Google створив алгоритми для обчислення якісних сайтів. Якщо трафіку майже немає, можливо на сайт було накладені санкції (перевірити можна в Google Analytics, Search Console).

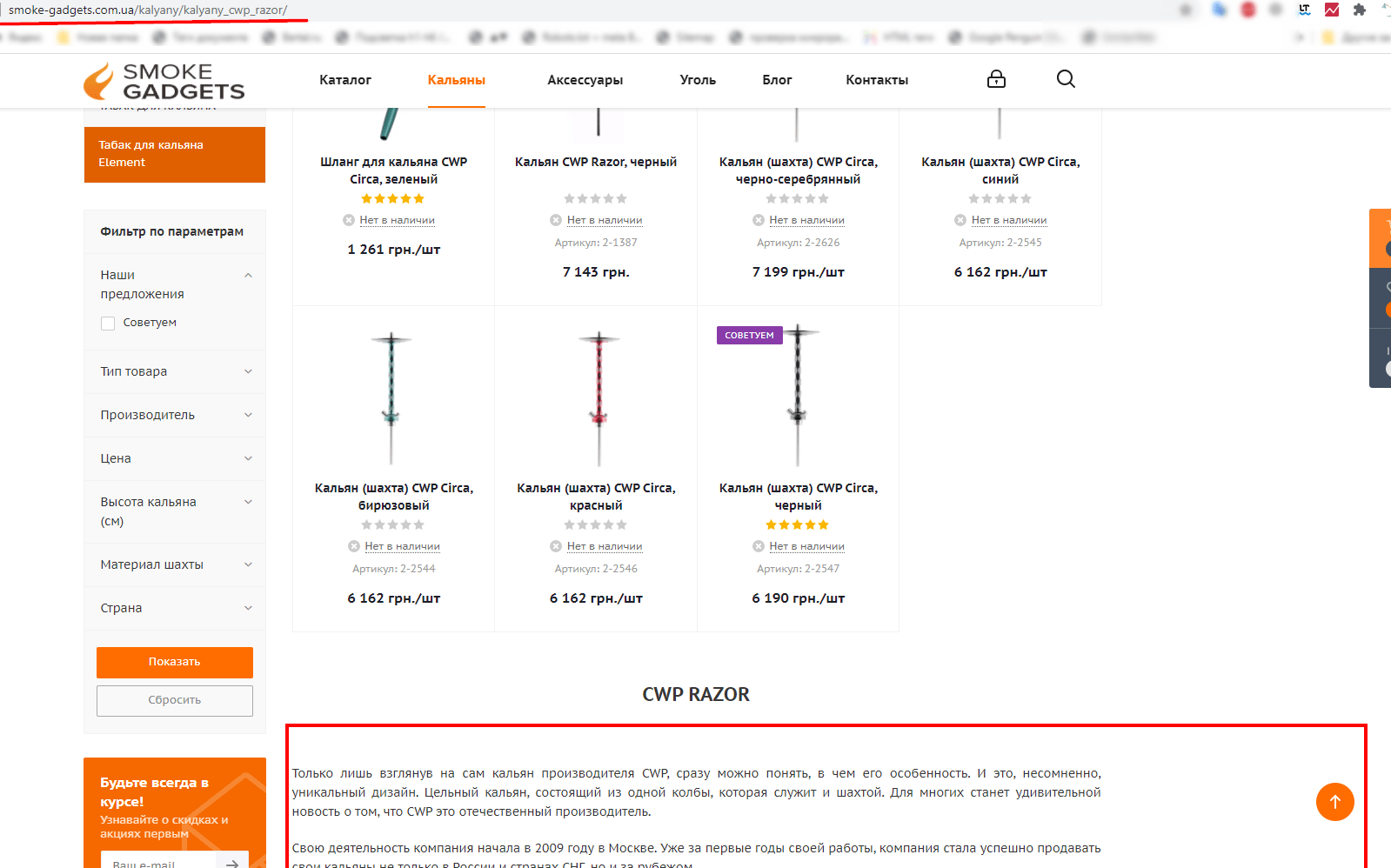

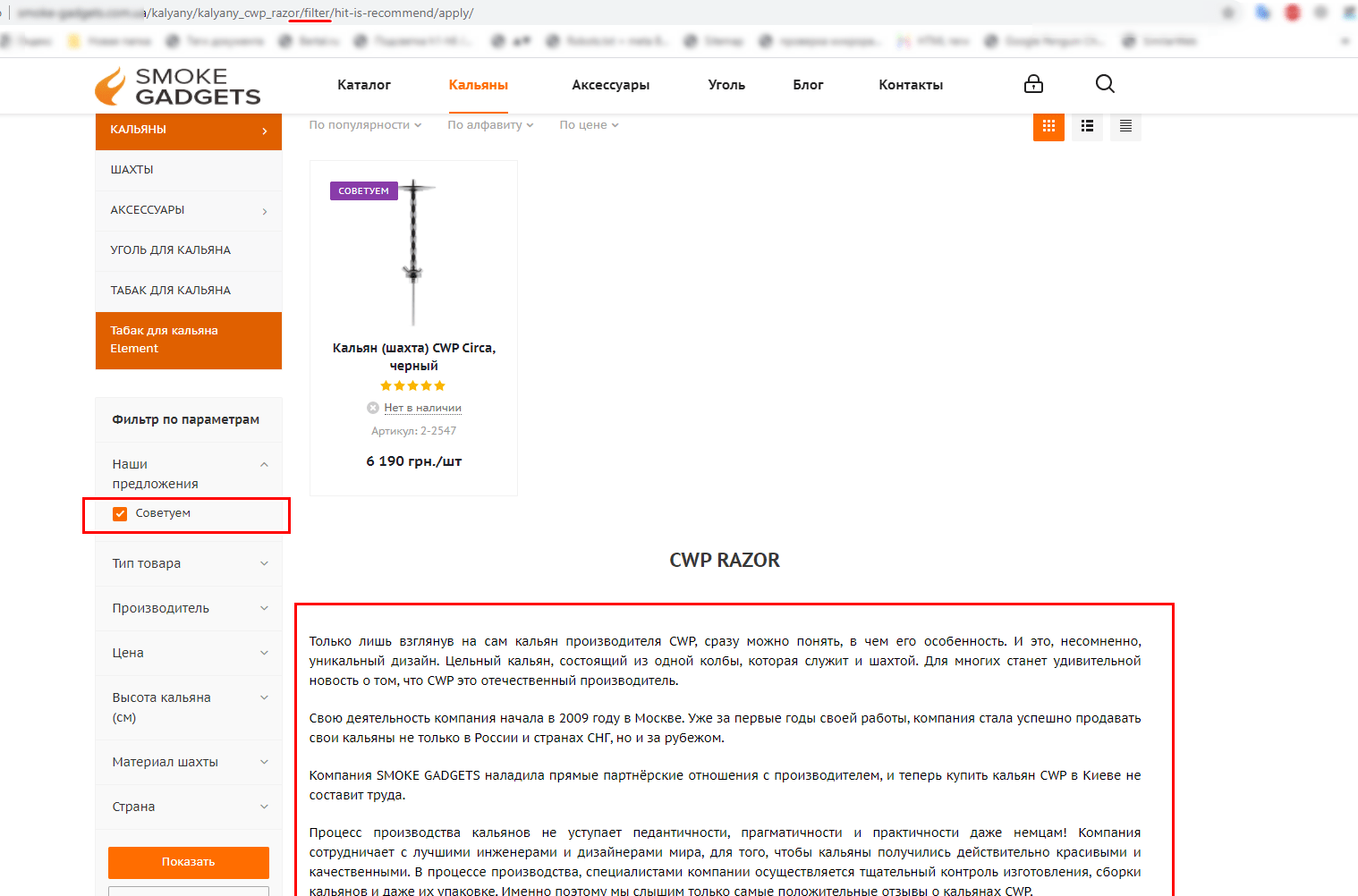

- Неякісний контент (неунікальний, неінформативний, дубльований) і дублі сторінок. Дублі сторінок — це сторінки, оптимізовані під однакові запити, але на різних url-адресах. Загальний обсяг сайту збільшується шляхом таких дублів, боти, своєю чергою, витрачають більше часу на індексацію цих «сміттєвих» сторінок, тим самим неефективно витрачаючи краулінговий бюджет сайту, а якісні сторінки можуть зовсім не потрапити в індекс.Повертаємося в поняття «краулінговий бюджет», де пошукові роботи витрачають на сканування сайту n часу. Якщо робот «бачить», що контент регулярно повторюється, індексація буде проводитися значно довше або може зовсім припинитися. Пошуковик вважатиме контент неякісним, не побачить сенсу його взагалі або часто сканувати.Дублюватися можуть не тільки сторінки, а й контент. Дублі контенту — повторювані матеріали на різних сторінках сайту (часто зустрічаються на сторінках пагінації, фільтрів або сортуваннях). Ось приклад дубльованого контенту на сторінках, які не закриті від індексації: http://smoke-gadgets.com.ua/kalyany/kalyany_cwp_razor/filter/hit-is-recommend/apply/

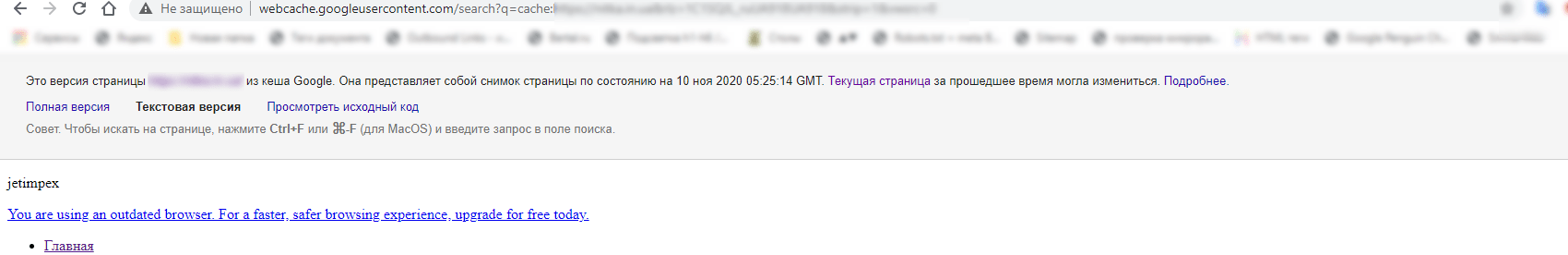

- Помилки в коді сайту. Пошуковий робот повинен обробити HTML-код. Якщо сторінки зроблені на JavaScript, то пошуковий бот не зможе розпізнати їх, обробити й додати в кеш пошукової системи. Щоб перевірити кеш сторінки, потрібно додати до неї cache: і переглянути текстову версію:

- Неправильна відповідь сервера на потрібні сторінки. Сторінка, що доступна для індексації, має віддавати код відповіді сервера 2хх. Якщо цього немає, не буде й індексації. Для пошукових роботів кожна група відповідей сервера дає вказівки, що потрібно робити:

3хх означає, що потрібний контент розташовано за іншою адресою;

4хх — сторінка не доступна;

5хх — проблема з сервером;

і тільки група відповіді сервера 2хх означає, що сторінка доступна за поточною адресою, отже її можна сканувати та індексувати. Якщо сервер дає невірний код відповіді потрібної сторінки, сторінка не потрапить в індекс. - Великий рівень вкладеності. Від вкладеності залежить пріоритетність сторінок під час індексування пошуковими ботами. Чим більше рівень вкладеності, тим менше у неї пріоритет: якщо ви створили нову сторінку або нову категорію, але для того, щоб до неї дістатися користувач повинен зробити більше 3-х кліків — швидкість індексації такої сторінки буде не високою. Наприклад: https://remshop.com.ua/p1007251549-kryshka-blendernoj-chashi.html

- Зайти на сайт.

- Перейти в категорію «Для кухонних комбайнів».

- Далі — на підкатегорію «Кришка чаші».

І тільки після цього можна буде перейти на потрібну картку товару. Погодьтеся, не швидко.

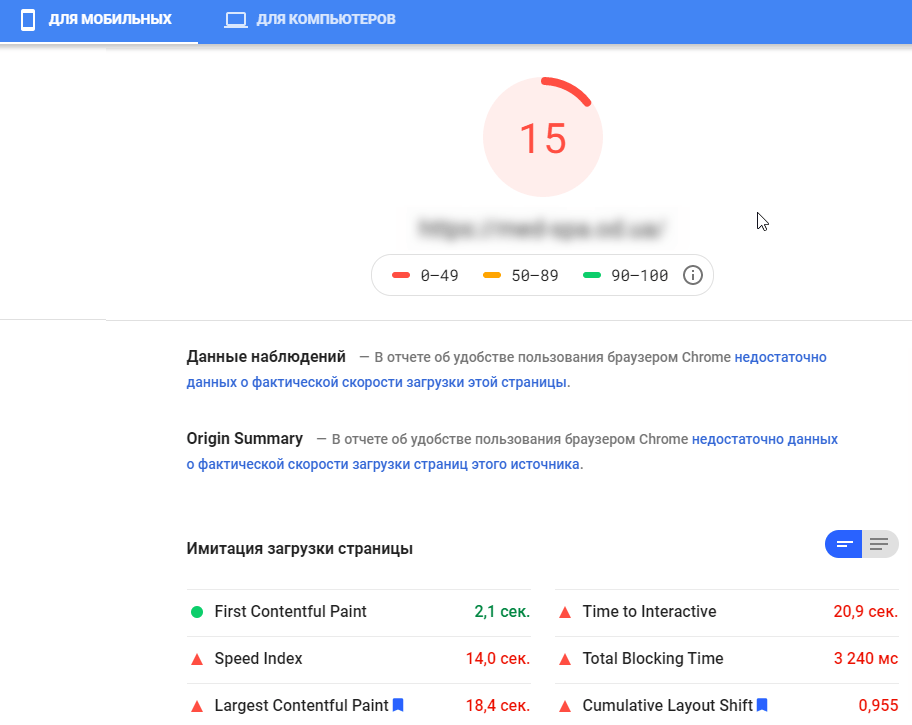

- Повільна швидкість сайтуШвидкість завантаження сторінок умовно складається з трьох складових:

- швидкість завантаження контенту;

- швидкість завантаження зображень;

- швидкість відповіді сервера.

Чим менше у вас розмір контенту, зображень і вище швидкість завантаження сервера, тим швидше бот просканує сторінку та додасть її в індекс.

- Відсутність мобільної версії. Здавалося б, до чого тут мобільна або адаптивна версія сайту до швидкості індексації сторінок пошуковою системою. Але з 1 липня 2019 року пошукова система віддала пріоритет мобільному контенту. Якщо сторінки відсутні в мобільній або адаптивній версії вашого сайту, пошукова система їх може будь-коли побачити.

- Чи не регулярне оновлення контенту сайтуЧастота оновлення контенту сигналізує пошуковому боту про її регулярність. Якщо на сайті давно нічого не публікувалося або не додавати нові товари, робот не буде ставити в пріоритет сканування та індексування вашого сайту. Наприклад, ви створили інтернет-магазин, наповнили його товарами, контентом і всіма необхідними даними. Тут можна подумати, що робота над сайтом закінчена і потрібно просто акцентувати на посилальному профілі. І ось ви регулярно розширюєте його, а результату немає. У чому ж проблема? У тому, що сайт без постійного оновлення контенту (асортименту), здається пошуковому боту «мертвим», а отже — час витрачати на нього не варто.

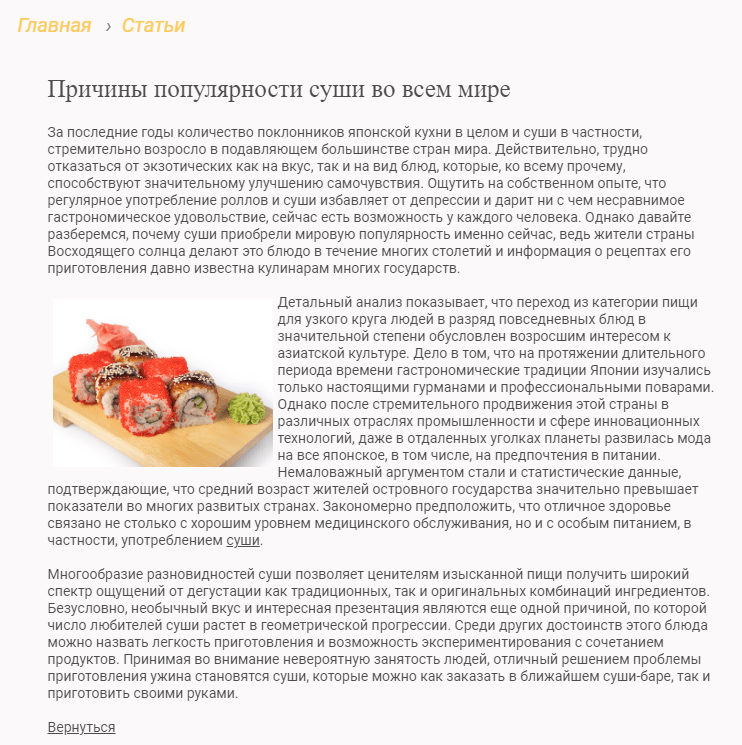

- Відсутність внутрішнього перелінкуванняПерехід за внутрішнім посиланням сприяє прискоренню індексації нових сторінок. Чим більше лінків веде на сторінку, тим більшу вагу вона набуває, тобто стає більш значущою для пошукових систем. Наприклад, на цю сторінку веде тільки одне посилання з переліку статей: http://eco-food.com.ua/articles/sushi-is-popular/

Як дізнатися, що сайт погано індексується

Спосіб №1

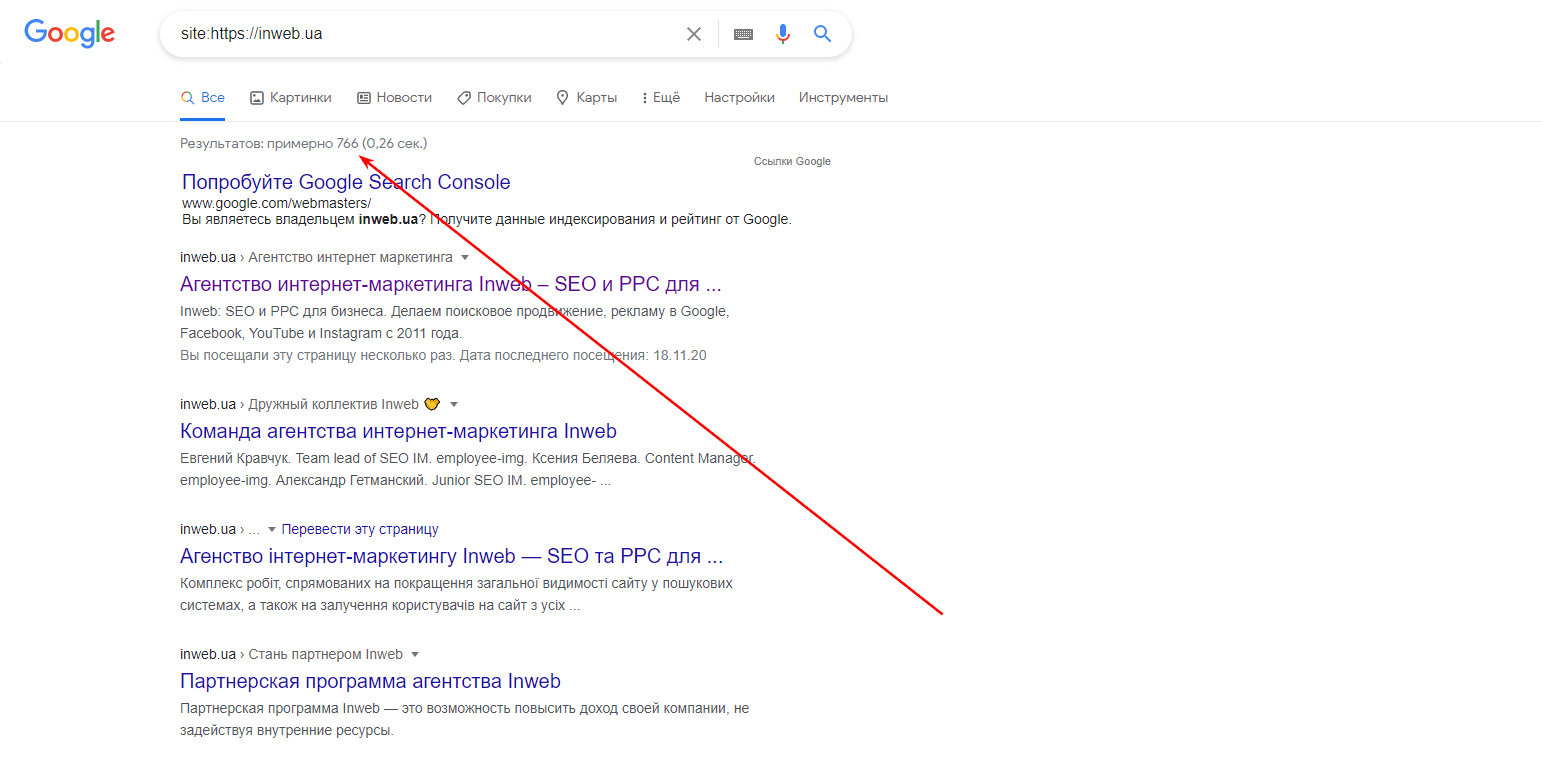

В адмін панелі дивимося загальну кількість сторінок вашого сайту, а потім в пошуковому рядку до домену додаємо site: Приклад: site: https:/домен.org

Під пошуковим рядком ви побачите кількість результатів, які знайшла пошукова система у видачі з вашим доменом. Далі потрібно зробити порівняння кількості сторінок в адмін панелі з кількістю сторінок у видачі. З різниці робимо висновок, скільки сторінок ще не проіндексовано.

Спосіб №2

Порівнюємо кількість сторінок з адмін панелі з даними з Search Console.

Приклад: Всього проіндексованих сторінок в Search Console:

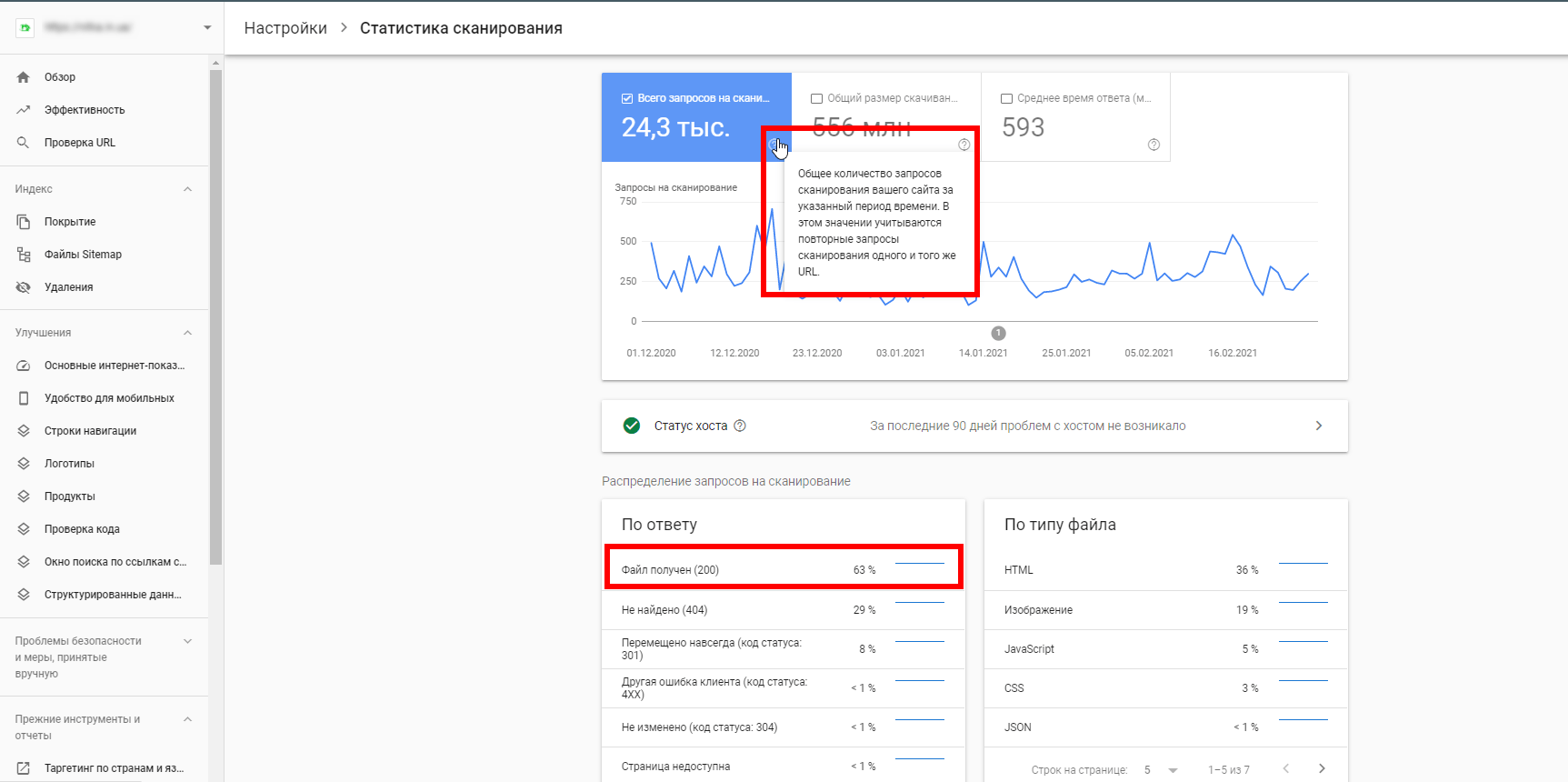

Також можна подивитися звіт “Статистика сканування”

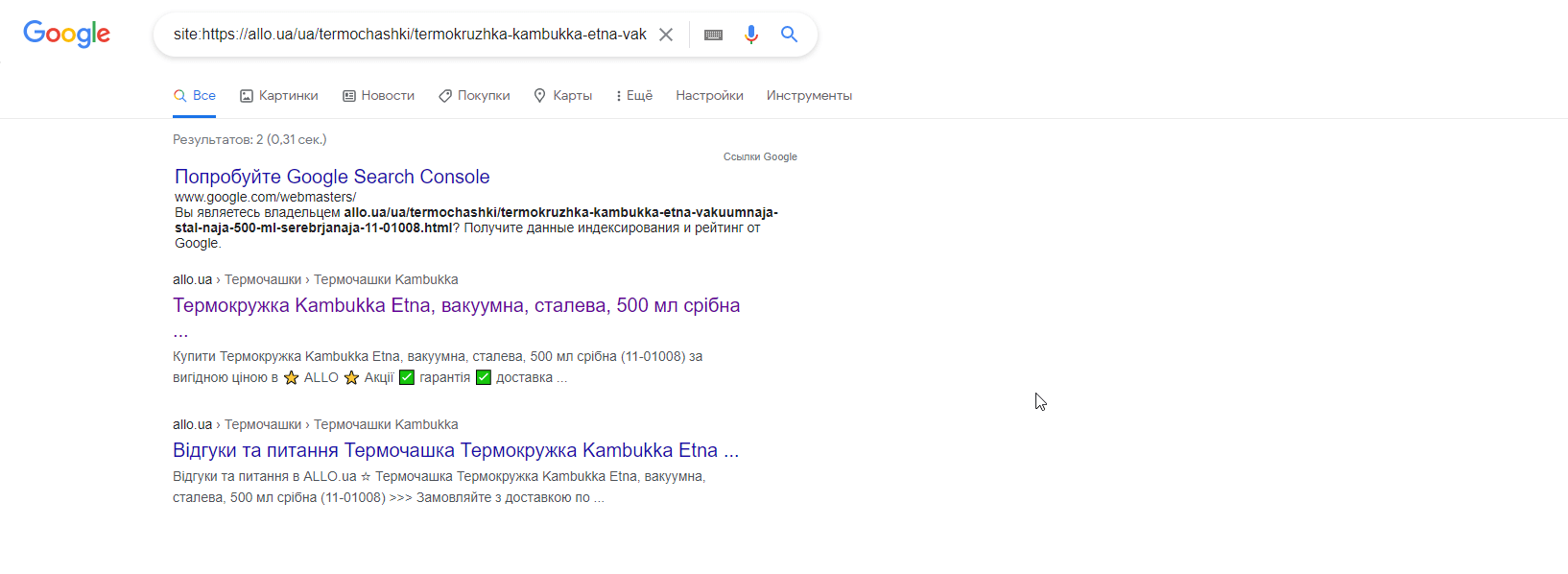

Спосіб №3

Можна подивитися, чи є конкретна сторінка у видачі, використовуючи той самий алгоритм, що і в способі №1. В цьому випадку потрібно додати site: з конкретною url-адресою. Приклад:

12 методів прискорення індексації сайту

Підсумовуючи вище описане, ми підготували 12 дієвих методів для поліпшення індексації сайту пошуковою системою Google.

- Оновлення поточного контенту.Один зі способів привернути пошукових роботів — це регулярне оновлення контенту на вашому сайті. Оновлення контенту може відбуватися шляхом перепису старого контенту або його окремих частин, наприклад, шляхом написання нових відгуків на старі сторінки сайту.

- Додавання нового контенту. Домогтися залучення уваги пошукових роботів до вашого інтернет-ресурсу можна шляхом додавання нового контенту на сайт. Для цього можна регулярно писати нові статті на блог, додавати нові товари, категорії або інформаційні сторінки.

- Відсутність дублікатів і сміттєвих сторінок. Як ми писали вище, на сканування кожного сайту виділяється n часу пошукового робота. Відсутність дублів і / або сміттєвих сторінок сайту збільшить кількість часу пошукових роботів на сканування потрібних сторінок. Як визначити, то що на сайті є сміттєві або дублі сторінок? Почніть з самого простого: перевірте коректність оптимізації сторінок пагінації, фільтрів і сортувань на сайті. Перевірте доступність сторінок з /, www і без. Якщо у вас зроблена ця оптимізація, проскануйте сайт спеціальними SEO-програмами, наприклад Netpeak Spider чи Screaming Frog, зверніть увагу на дублі метатегів.Сторінки, оптимізовані під однакові запити, також є дублями в «очах» пошукової системи.

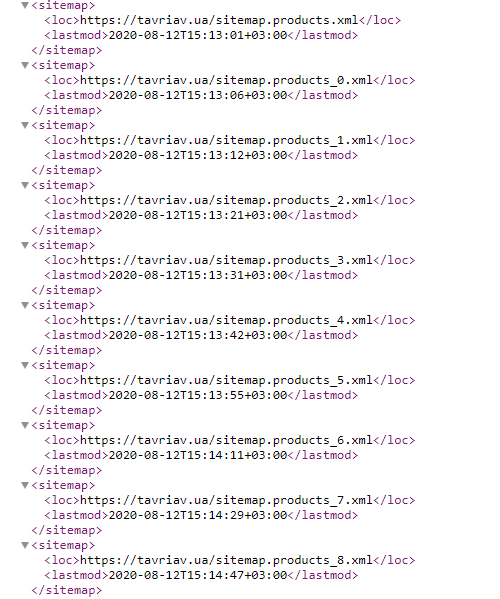

- Створити коректний і автообновлювальний Sitemap.xml.Для прискорення індексації сайту, створіть коректну xml-карту і додайте її в файл robots.txt і Веб-майстер. Вона буде, свого роду, навігатором вашим сайтом для пошукових систем. А додавання в неї Last-Modified вкаже ботам дату останнього оновлення конкретної сторінки та скануватиме сторінки з новим контентом швидше.

- Зовнішні ресурси. Розміщення посилань на сторонніх ресурсах або лiнкбилдiнг не тільки допомагає збільшити контрольну вагу сайту в цілому або конкретної його сторінки, а й залучає пошукового бота для поліпшення індексації. Кілька способів розміщення посилання на ваш сайт на сторонніх ресурсах:

- форуми;

- рейтинги;

- статті;

- довідники;

- отзовікі.

У поточній рекомендації важливо вибрати якісні інтернет-ресурси з хорошими показниками, такими як відвідуваність майданчиків, кількість вхідних і вихідних посилань, основні ключові слова ранжирування сайту і приналежність до регіону, в якому ви рухаєтеся.

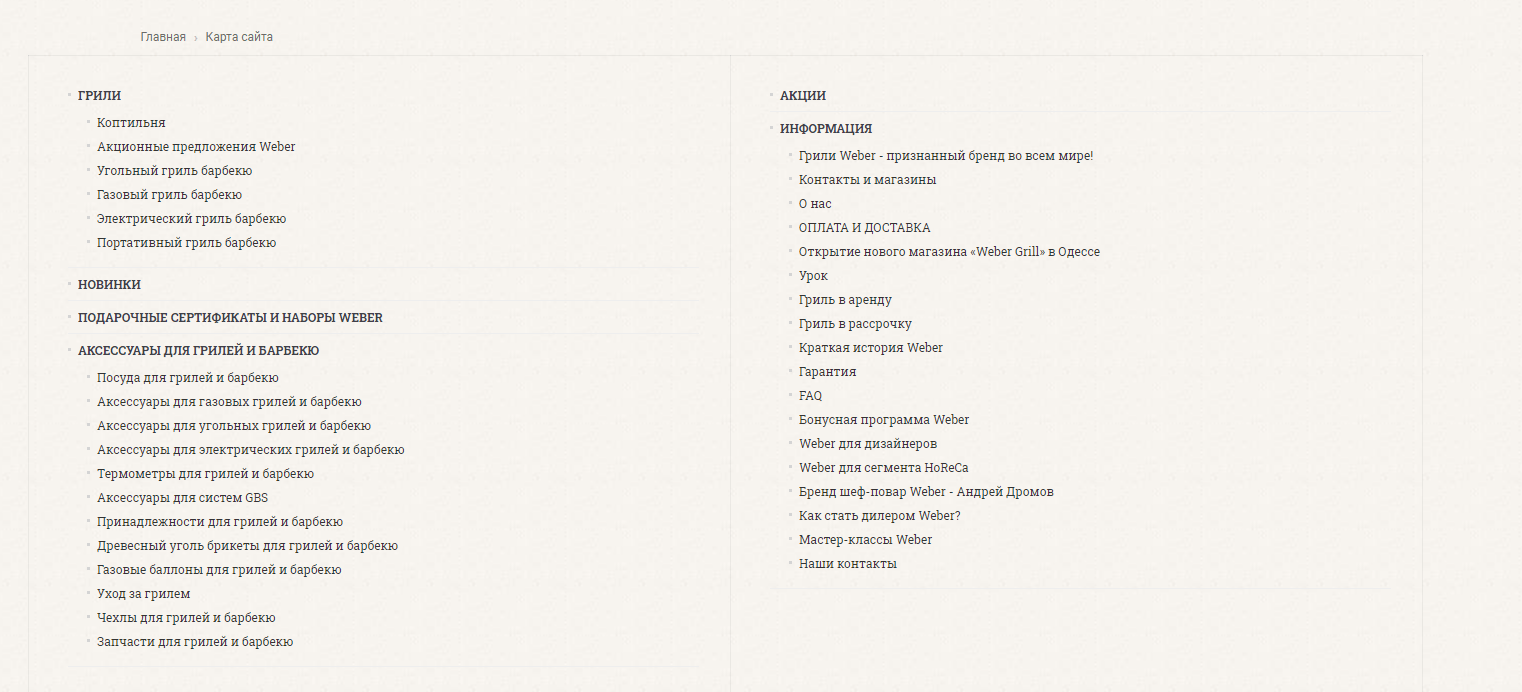

- HTML-карта сайту для категорій, а також для підтвердження бронювання.Карта сайту в форматі HTML — це, свого роду, каталог усіх розділів сайту з категоріями та підкатегоріями, розміщених відповідно до їх ієрархії. Наявність html-карти сайту показує пошуковій системі, які сторінки є основними та зменшує рівень вкладеності для підкатегорії.

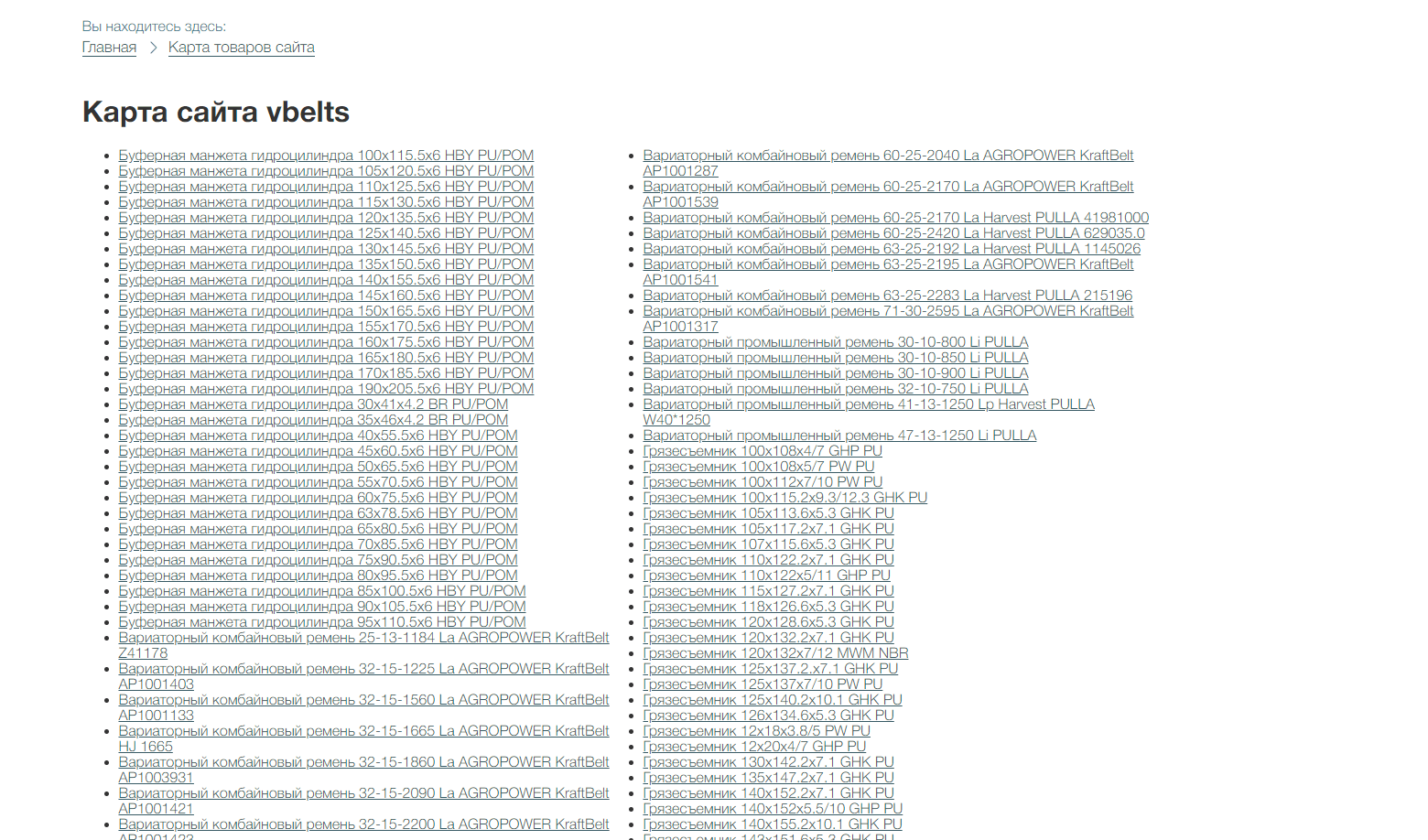

- HTML-карта сайту для карток товару.Цей спосіб покращення індексації добре підходить для великих інтернет-магазинів: всі картки з товарами знаходяться в одному місці та є, свого роду, путівником для пошукової системи за асортиментом.

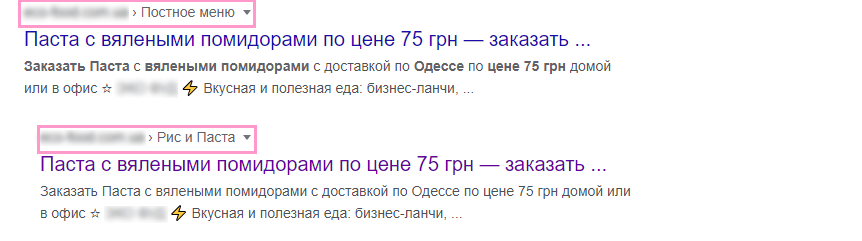

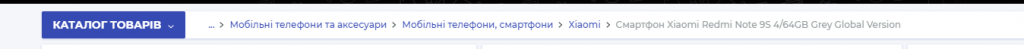

- Хлібні крихти.Елемент інтерфейсу на веб-сайтах, що показує шлях від початкової сторінки до рівня, який зараз переглядає користувач. Хлібні крихти є елементом додаткової лінківки, яка в цілому впливає на поліпшення індексації.

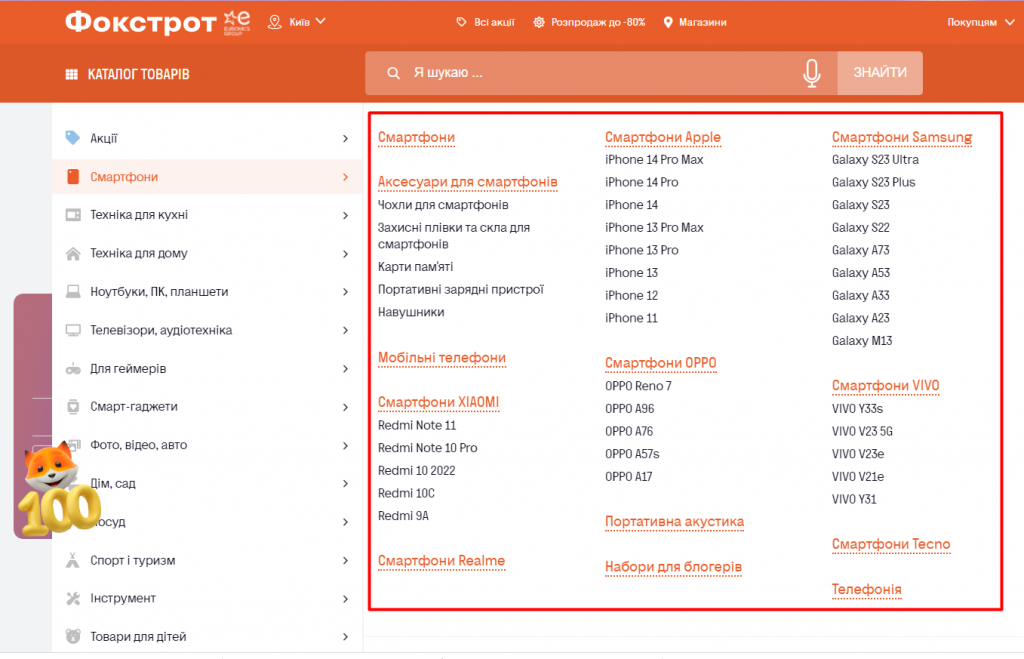

- Випадаюче меню. Як швидко бот дістанеться потрібної сторінки, залежить від рівня вкладеності. Найкращий результат вкладеності сторінок – не більше 2-3 кліків. З цією метою багато веб-ресурсів створюють меню, що випадає, в яке виводяться всі основні посилання на розділи і категорії.

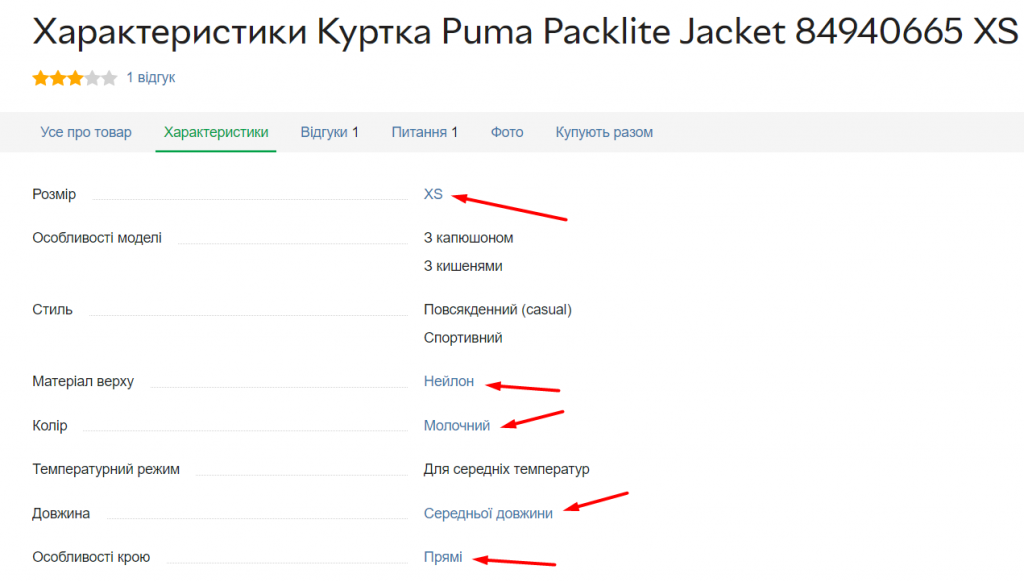

- Перелінковка за характеристиками на картках товарів. Посилання в характеристиках на картках товару, що ведуть на відповідні категорії або підкатегорії, є елементом додаткової лінківки, яка впливає на покращення індексації.

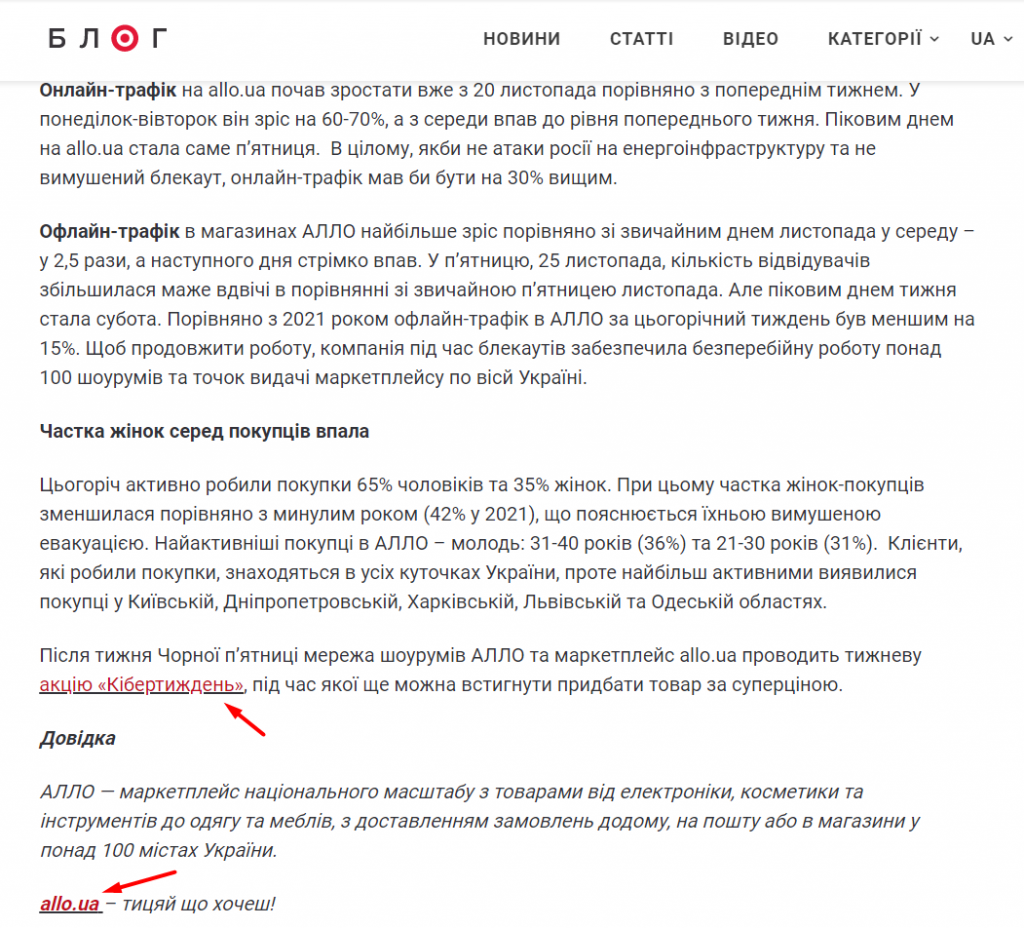

- Посилання в контенті. Щоб пошуковий бот якнайшвидше зайшов на нові сторінки сайту, поставте посилання з вже проіндексованих сторінок на нові. Проставлені посилання в контенті повинні вести на релевантні сторінки категорій.

- Мобільна або адаптивна версія сайту. Як вже говорили, якщо сторінки відсутні у вашій мобільній чи адаптивній версії, то пошукова система їх може не побачити. Переконайтеся, що всі рекомендації, описані вище, доступні у мобільній або адаптивній версії сайту. Якщо це не так, почніть працювати над своєю індексацією саме з цього пункту.