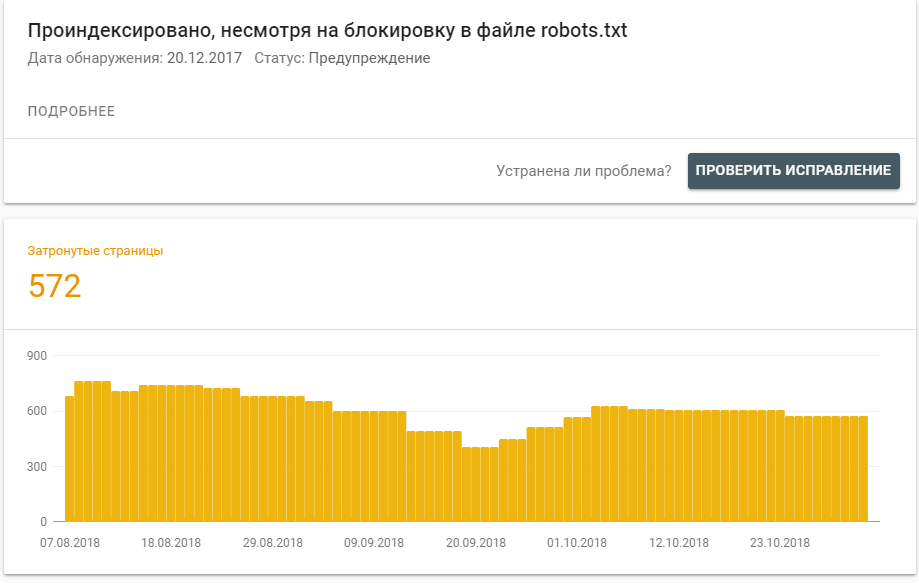

Проиндексировано, несмотря на блокировку в файле robots.txt

Есть ответ Дата вопроса: 05.11.2018, 19:01 В новой версии инструментов для вебмастеров от гугла есть раздел «Проиндексировано, несмотря на блокировку в файле robots.txt» и там указано более 500 страниц. Всем этим страницам мы заблокировали индексирование в robots.txt, почему они проиндексированы, ведь правила индексирования указаны? стоит ли обращать внимание на этот отчет?

|

| Частный ответ Рейтинг автора 188 Дано ответов 77 Влад Наумов Head of SEO Добрый вечер, спасибо за интересный вопрос. Дело в том, что для поисковой системы Google в файле Robots.txt прописываются правила сканирования ресурса, но не индексирования. Т.е. сканирование может быть запрещено, но поисковая система может добавить в индекс данный url-адрес, так как может найти его другими способами. Поисковая система Яндекса, в отличие от Google, использует файл Robots.txt как правила сканирования и индексирования. Яндекс всегда следует директивам в файле Robots.txt. Справки поисковых систем Google и Яндекс по работе с файлом Robots.txt. В новой Search Console появился очень интересный и полезный отчет «Проиндексировано, несмотря на блокировку в файле robots.txt», который содержит все url-адреса сайта, которые добавлены в индекс, хотя и заблокированы в файле Robots.txt. Это является проблемой, так как проиндексированы некачественные документы. Некачественные документы в индексе поисковой системы негативно влияют на ранжирование сайта. Следовательно данную проблему необходимо решить следующим образом:

Исходя из нашего опыта, если таких страниц в индексе очень много, то решение данной проблемы приведет к существенному улучшению ранжирования сайта в поисковой системе Google. Дата сообщения: 05.11.2018, 19:20 Похожие вопросыНе приходит код от Google Мой бизнес Ruf, 17.06.2019 Как ускорить переиндексацию новых url категорий? Кирилл, 17.04.2019 Сайты на одном адресе аффилиаты? Анатолий Икорский, 28.11.2018 |